财报超预期!交换机龙头Arista印度制造计划落地,产业链或迎重估

继超预期财报发布后,AI网络设备龙头 Arista Networks 再次释放战略信号。

7 月 30 日,Arista 正式宣布在印度开展 “Make in India” 战略,扩展在印企业级网络与 AI 创新投入,通过本地制造与人才培养提升市场覆盖与竞争力。

这不是一项单纯的市场拓展动作,而是 Arista 全面构建“云-边-端” AI 网络版图的关键一环。

一、印度制造落地,全球化AI布局提速

此次“Make in India”战略发布,Arista 计划在印度设立本地制造与研发中心,覆盖高性能数据中心交换机、校园网络设备、无线接入方案等多个产品线,目标不仅是满足印度本土市场,更是打造亚洲地区 AI 网络设备的交付中心。

Arista 将通过以下三大路径强化其全球化供应链优势:

l 制造本地化 :核心产品将在印度完成装配生产,提升交付灵活性;

l 人才本地化 :预计未来三年内培训逾万名工程师,增强技术本土支撑力;

l 创新本地化 :AI 驱动网络解决方案将深入贴合新兴市场需求,实现差异化定制。

在地缘政治波动与全球链路紧张背景下,Arista 此举显然是围绕 AI 基础设施全球落地进行的一次“地理安全布局”。

二、AI大客户订单爆发,核心业务全面超预期

美东时间 7 月 30 日周二盘后,Arista 公布 2025 财年第二季度财报,核心业务实现全线高增长:

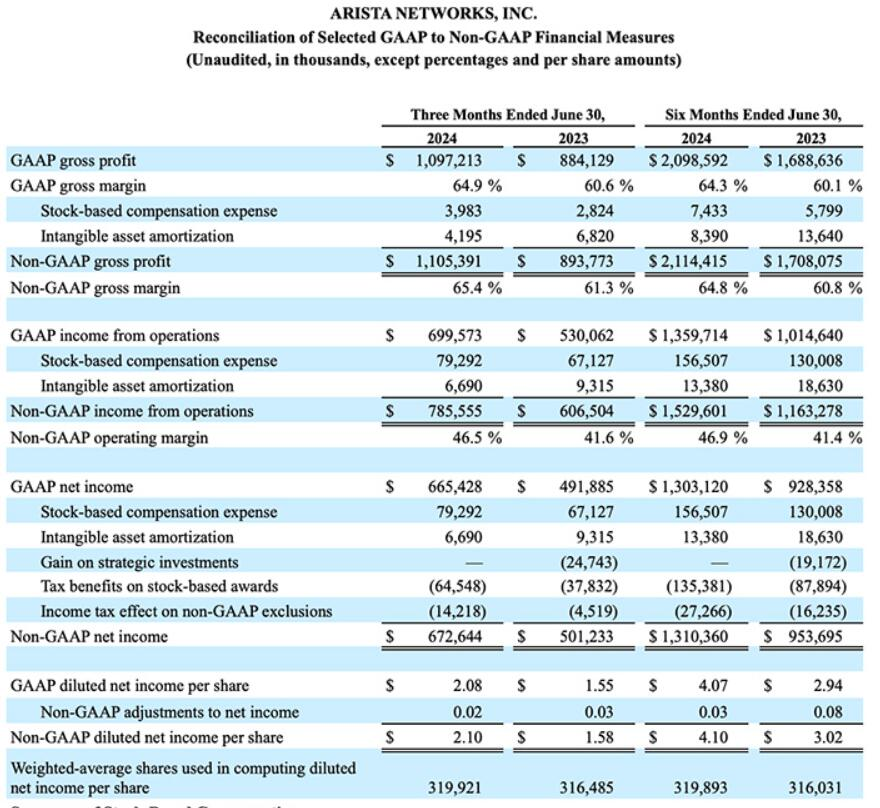

l 营收 :16.9 亿美元,同比增长 15.9%;

l 净利润 :6.726 亿美元,同比增长 34.2%;

l 毛利率 :调整后毛利率达 65.4%,高于上季度的 64.2%;

l 每股收益(EPS) :调整后 EPS 为 2.10 美元,同比增长 32.9%。

CEO Jayshree Ullal 在电话会议中直言:“AI 数据中心部署正进入高密度阶段,我们的核心客户订单仍处在持续增长通道。”

特别值得注意的是,微软与 Meta 两家客户合计营收贡献占比已超过 43% ,AI 订单的确定性正在转化为实打实的财务释放。

同时,Arista 在 800G 与 1.6T AI 高密度交换机 领域已实现量产部署,正在逐步替代 40G/100G 旧代设备,直接受益于 AI 推理对超低延迟、高带宽连接的刚需。

三、AI主线切换,瓶颈从“算”转向“传”

GPU 热潮渐退,网络硬件即将登场。

市场长久以来高估了算力芯片的主导性,却低估了网络结构在模型推理性能中的作用。从实际落地看,决定 AI 模型吞吐效率的,不是 H100 的数量,而是 GPU 节点间的互联效率。

AI 训练的战场在 GPU,AI 推理的瓶颈在网络。

而 Arista 正是少数具备全栈 AI 网络能力的玩家之一,其代表性架构“AI Spine ”已成为诸多 AI 数据中心的默认网络底座。

AI 网络设备正在迎来以下几个结构性变化:

l 高密度交换机需求爆发;

l AI 集群规模推升网络结构扁平化;

l Spine-Leaf 架构与 800G/1.6T 接入将成标配;

l 网络延迟将直接影响 LLM 模型响应速度与单位成本。

过去算力生态的焦点是 GPU,接下来的焦点将是 “谁让 GPU 跑起来” 。

四、下一波AI红利,Arista正当其时

相比 GPU 厂商的周期波动,Arista 作为“连接层的控制权”玩家,具备 稳定订单、技术壁垒与高利润模型 的“三重护城河”。

当前,不论是数据中心内部互联,还是“云—边—端”的协同扩展,AI 网络(数据中心内部、尤其是GPU服务器之间的“通信主线”)已经成为决定 AI 商业化效率的核心变量。

Arista 不再只是通信设备商,而是 AI 基础设施的核心枢纽企业 。