训练与推理:AI芯片的两条路

一、一场看得见的战争

你天天用的豆包、DeepSeek、Kimi,背后其实有两类芯片在默默干活。

训练芯片,好比老师,用海量数据把模型灌熟。

推理芯片,好比考场,随时回答用户的问题。

资本市场过去两年盯着训练芯片——GPU(图形处理器)是黄金,英伟达成了新图腾。但你有没有发现?训练只是一次次砸钱买门票,而推理才是日复一日的电费账单。谁能把推理成本砍下来,谁才是真正的赢家。

换句话说:训练是“造神”,推理是“落地”。造神惊艳一时,但要让神明天天在街上给你搬砖,你得先算账。

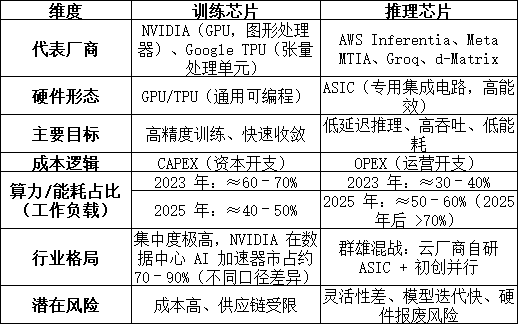

二、训练芯片:巨头的城墙

训练的逻辑很简单:你要教会模型识别猫狗,必须喂它几百万张图片,让它不断调参数,不断迭代。

这活儿,极度烧钱、极度耗算力。于是 GPU、TPU(张量处理单元,Google 自研芯片)这样的“通用武器”成了标配。

代表选手 :英伟达 H100/B200(数据中心 GPU),Google TPU v5p(训练芯片)。

核心需求 :显存大、互联快,能撑得住几千亿参数的同步计算。

核心特征: 资本开支 CAPEX(Capital Expenditure,资本性支出),一次性买入,越狠越好。

虽然公开报告罕有“训练 vs 推理”的详细分割,但从行业趋势看,2023 年训练大约占据数据中心 AI 芯片算力的 60–70%,推理约为 30–40%;到 2025 年,推理可能增长到 50–60%,训练回落至 40–50% 。

注:这里的数据口径是算力/能耗占比,而不是芯片收入。训练和推理在收入上暂无权威拆分。

这种结构性转变意味着:训练可能建造了 AI 的“基础设施”,但推理正在成为绝大多数「算力消费」的主力。

三、推理芯片:大众的入口

别以为训练完就大功告成。模型上线,每一次调用都是推理。你问一句话,它就要算一大串矩阵。百万用户同时在线?那就是千万次推理。

推理要什么?

快 :用户不能等你十秒钟才出答案。

省 :电费不能比营收还高。

稳 :每天 24 小时不停歇。

于是 ASIC(专用集成电路)上场了。它是为推理场景定制的,不讲花哨,只讲效率。AWS(亚马逊云服务)有 Inferentia,Meta 推出 MTIA(Meta 推理加速器),Groq、d-Matrix 这些新创厂商更是主打“能效比秒杀 GPU”。

市场变化更直观:根据 MarketsandMarkets(国际市场研究机构)的预测,2025 年全球 AI 推理整体市场规模将达约 1061 亿美元,到 2030 年有望突破 2500 亿美元,CAGR(年复合增长率)约 19–20% 。

注:该口径为 AI 推理整体市场,涵盖芯片、内存、网络、软件等投入,不仅限于芯片收入。

推理不是一次性买卖,而是“长尾需求”——只要用户还在调用,推理就永远存在。

四、本质的区别:老师 vs 考生,CAPEX vs OPEX

一句话总结:

训练芯片 = 老师,重在培养学生。

推理芯片 = 考生,重在天天答题。

训练是一次性投入,推理是长期账单。资本机构更看重谁能降低推理成本,因为它决定了应用能否普及。

现实例子:一个千亿参数的大模型,训练一次可能烧掉几千万美元。相比之下,推理不是一次性支出,而是每天几亿次调用、年复一年的电费账单。

所以别再被 GPU 的神话迷住。训练端英伟达固若金汤,但推理端,它并不是唯一答案。

五、为什么推理芯片是下一个风口?

(1)数据:推理量爆炸

英国《金融时报》报道:到 2025 年底,全球数据中心 > 75% 的算力与能耗将用于推理。

巴克莱研究也指出:到 2026 年,推理相关资本支出接近 1200 亿美元 ,而且增长势头还将持续。

(2)应用场景广泛

云端 :豆包、DeepSeek、Kimi 等大模型应用,每一次对话、每一次搜索背后都是推理。

边缘 :IDC 预测,到 2027 年商用 PC 中 AI PC 占比约 60% ;Counterpoint 预测,GenAI 手机渗透率 2027 年约 40–45% ,到 2028 年超过 70% 。

车载 :自动驾驶 ADAS(高级驾驶辅助系统),实时推理直接决定安全,毫秒级延迟都可能致命。

(3)经济逻辑倒逼

AI 不可能永远靠“烧钱补贴”。真正的战场在推理:谁能把单次调用成本压到几分钱甚至更低,谁就能撑起一门生意。

六、冷逻辑:推理并非“救世主”

热闹背后有冷逻辑:

灵活性问题 :ASIC 芯片定制化高,一旦模型迭代快,硬件可能过时。

开发风险 :芯片从设计到量产(Tape-out,流片)少则一年,多则两三年,场景一变可能血本无归。

GPU 的韧性 :虽然贵,但灵活,既能训练也能推理。企业不会轻易抛弃 GPU。

所以未来格局不是“推理取代训练”,而是混合:云端依旧靠 GPU/TPU 撑底盘,边缘和特定场景由 ASIC 推理卡切入。

换句话说,推理芯片是新蓝海,但不是万能药。

七、产业格局观察

解释

口径说明 :这里用的是 工作负载(算力/能耗)占比 ,而不是市场收入。因为训练和推理在“芯片出货收入”上缺乏精确拆分,但在算力消耗上趋势明确,且有机构数据支持。

数据依据 :

2023 年:训练主导,占约 60–70%,推理 30–40%。

2025 年:推理占比上升至 50–60%,训练降至 40–50%。

2025 年后:多家机构预测 > 70% 算力/能耗来自推理(FT、摩根士丹利、AMD CTO 等)。

八、结语

训练是神坛,推理是江湖。

前者决定 AI 的高度,后者决定 AI 的广度。

未来 AI 产业,谁能让推理又快又便宜,谁就能拿走时代的入场券。

这不是哲学,而是赤裸裸的产业逻辑:

训练让人仰望,推理让人掏钱。

训练是起点,推理才是终局。