深度解读:散热新周期,MLCP凭什么被英伟达点名?

引言:英伟达逼出的“冷兵器革命”

很多行业的转折点,都是在大家觉得逻辑稳得不能再稳的时候突然变脸。兵法里有句话:“水无常形” ,放在AI也说得通——算法在进化,芯片在迭代,而冷却的门槛也在被不断抬高,逐渐成为算力版图的边界。

最近有产业链消息称:英伟达正要求供应商研发“微通道水冷板(MLCP)”,据悉已进入重点评估/验证阶段(尚未官宣)。为啥?因为新一代GPU功耗据说要冲破2000W大关。你想象一下,机柜里一堆小火炉往外狂冒热气,空气冷却早就没戏了,传统冷板再怎么加厚加水,也顶不住——就像拿木桶去接瀑布,根本兜不住。

你以为算力的瓶颈在晶体管?

你以为大模型拼的是参数量?

但真相很扎心——冷却要是搞不定,再贵的GPU也只能当“暖手宝” 。

更绝的是,有传闻说这种MLCP的价格,比现有冷板贵三到五倍。正常人听到这种价差肯定先摇头,可英伟达偏要往前推。意思很清楚:哪怕多花钱,也要先把这团热压下去。

对投资者来说,信号早已不是“液冷重要”——那已经成了共识。真正值得关注的是:连现有液冷板都撑不住新的功耗需求,产业正被迫走向更高门槛、更高成本的新阶段。

MLCP的意义,不是能不能跑,而是能不能高效、稳定、算得过账。

一、MLCP是什么?

很多人第一次听到“微通道水冷板(MLCP)”,脑子里都是问号:这玩意儿和普通冷板到底有什么差别?

一句话可以说清:传统冷板是“水管贴在芯片外壳”,MLCP则是在盖板(IHS)或冷板基底里直接开出微米级的流道,让冷却液更靠近裸晶热源,缩短传热路径 。

再展开一点:

· 传统冷板 :芯片发热→热量穿过导热膏(TIM)、盖板(IHS)→传到冷板金属面,再由流过的冷却液带走。路径长、层次多,热阻大。

· MLCP :在IHS或冷板基底中集成微通道,冷却液几乎“贴身”流过发热区域,第一时间把热量带走。

如果用比喻来解释:

普通冷板=穿着厚外套再吹风扇,热量要先透过衣服。

MLCP=把冷水管缝进衣服里,直接贴在皮肤上,降温更快。

关键点就在“微通道” :通道越细,换热面积就越大,热阻下降,芯片温度更容易被压住。这样一来,即便GPU功耗提升到2000W级别,也有望在更可控的温度下运行,减少过热降频的风险 。

所以,MLCP不是普通冷板的“加强版”,而是一次散热思路的升级 。它要解决的,不是“能不能冷”的问题,而是在极限功耗下,能不能冷得更快、更稳。

二、为什么是现在?

产业里早就知道液冷是大势,但问题在于:为什么此刻,MLCP突然被推到台前?

第一,功耗曲线逼近新门槛 。过去液冷冷板还能兜得住800W、1000W的GPU,如今单卡要冲到2000W级别,这不是“冷不冷得了”,而是“冷得够不够快、够不够均匀”。若散热跟不上,轻则降频、重则影响集群稳定性与任务进度。

第二,AI应用进入长跑阶段 。早期训练可以“跑一阵歇一歇”,但大模型迭代要求数据中心连续数月、甚至全年不间断运行。换句话说,冷却要支撑的不只是峰值,而是长时间的稳定性。这对现有冷板的可靠性、均温性都是巨大考验。

第三,系统级约束全面抬头 。今天讨论冷却,已经不仅是“芯片热不热”的问题,而是整个数据中心的运营账。PUE指标(电源使用效率)要达标,电力成本要压下去,机柜密度要拉上来。冷却效率直接决定一度电能换来多少算力,算力能不能摊得平摊得稳。

所以,MLCP的出现,不是单点技术优化,而是被功耗、长时间负载和系统化运营三重压力共同推出来的 。这也是产业链出现“点名研发MLCP”说法的原因之一——在部分高功耗场景更具必要性。

三、它解决了什么?把热阻链路拆开

散热的关键,不是“加点水、加个风扇”,而是把热量快速、均匀、稳定 地送进冷却回路。现有方案的痛点主要有三类:

1.链路冗长、界面累积热阻

导热材料(填充芯片和散热部件之间的缝隙)有厚度,还会老化;芯片盖板(金属保护层)和冷板贴合不完美,容易出现微小缝隙。热量在多层界面里“磨蹭”,结温被拉高,响应速度变慢。

MLCP的改进 :把微通道直接做到盖板或冷板基底里,减少界面数量,缩短传热距离,把每一瓦功耗对应的温差压下来。

2.热点顽固、均温不足

高功耗芯片常出现局部“热峰”,即使平均温度不高,也可能触发降频。

MLCP的改进 :在主要发热区上方布置微通道,冷却液几乎“贴脸”流过,换热面积更大,热量被更快带走,热点被抹平,芯片运行更稳。

3.流量提升的副作用

传统办法是加厚冷板、提高流量,但这会导致更大的压力损失(液体流动受阻带来的能量消耗),泵功率、噪声和故障率一起上升。

MLCP的改进 :通过“就近换热”,提升每单位流量的散热效率,在同样的泵功下温度更低,或者在相同结温下减少能耗。

为什么MLCP能做到这些?

道理很简单:通道细了,水流和金属的接触面积更大;位置更近,热阻更小;分布更密,覆盖更均匀。副作用是阻力上升,但只要设计平衡好效率与能耗,就能在极限功耗下保持可控温度。

MLCP真正解决的,不是“有没有冷却”,而是“能不能在极限功耗下,又快又稳地把热量带走”。 它等于在散热这条路上修了一条直通高速,把过去的弯弯绕一刀切开。

而除了结构本身的优化,产业也在材料端寻找突破口。目前依然是硅基方案为主,据产业链交流口径,在测试环节已经有厂商尝试叠加多层石墨片,就像“切云糕”一样,利用石墨独特的单向导热性,把热量沿既定方向迅速传导。石墨材料的优势在于可以多次使用,便于自动化测试。整体来看,Rubin 系列的架构和主流材料不会有根本性变化,水冷头仍是核心,液体金属方案则还停留在验证阶段。

四、怎么看它好不好?

工程师盯着的是“结构怎么改”,投资者关心的则是“值不值得投”。那怎么看MLCP?别被一堆术语吓住,抓住这五个指标就够了:

1.热阻

热阻:可理解为同等功耗下的温升(越低越好)。热阻越低,芯片升温就越慢。这个数要是降不下来,MLCP就白忙活。

2.热通量

就是“单位面积能带走多少热”。热通量越高,机柜能塞的GPU越多,算力利用率就越高。对投资者来说,这直接对应收入空间。

3.均温性

看热点能不能被压住。别小看这个,一块芯片里有一块地方过热,就可能降频甚至宕机。大模型训练动辄几个月,这事可不是小麻烦。

4.压降

简单说就是“水流过不去要不要费劲”。压降太大,泵就得拼命干活,结果能耗、噪声、维护成本全涨。投资人要算的是整体账,而不是只盯着散热效果。

5.成本

传出来的价格是现有冷板的三到五倍。听上去离谱,但英伟达还是要推。为什么?因为它算的不是买板子的价,而是整个生命周期的账 :冷却更高效,机柜能多塞GPU,宕机少,算力产出就能把钱赚回来。

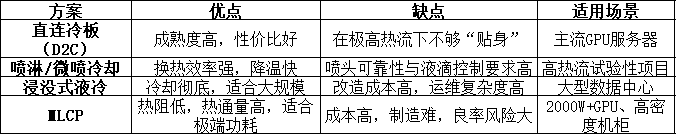

与主流方案横评

要看MLCP的定位,还得和几种主流方案横向对比:

MLCP的定位 :它不是要替代一切,而是在“超高热流+高密度”区间补位。未来更可能是多方案并存:中低功耗用冷板,大规模场景用浸没,极端GPU靠MLCP兜底。

投资者要记住 :

五个指标是判断MLCP技术成熟度的关键;

横评是看它在整个产业版图里的位置。

换句话说,MLCP不是银弹,而是补位选手 。最终能不能跑出来,就看它能否在性能和成本之间找到平衡。

五、供应链格局与技术路线

MLCP 并不是一夜之间冒出来的“黑科技”,而是整个供应链在摸索中的产物。

1. 市场讨论升温

据产业链消息,8 月下旬起台湾与外资圈开始热议 Rubin 可能采用微通道盖板。台股健策作为英伟达的主要盖板供应商,其股价走势一度被市场视为风向标。

2. 技术与客户接受度排序

业内交流普遍给出如下排序:

技术成熟度 :单相冷板 >> 双相冷板 = 浸没 > MLCP;

客户接受度 :单相冷板 >> 双相冷板 > MLCP >> 浸没。

换句话说,冷板依旧是多数客户的首选,MLCP 还在追赶阶段。

3. 供应链对比

在供应链层面,冷板厂和盖板厂正展开一场前哨战。

冷板厂(如 AVC、Auras 等) :优势在于积累了多年冷板层级的微通道加工经验,同时具备庞大的量产能力。据产业链消息,台湾奇宏 AVC、酷冷至尊Coolermaster 等厂商也在加速布局相关工艺与产线 ,希望在新一轮高功耗 GPU 带来的散热需求爆发时,能够抢先占位。

盖板厂(如健策) :优势在于先发卡位。作为英伟达的核心盖板供应商,健策的市场地位早早建立,一旦微通道盖板通过验证,有望直接切入核心环节。

业内共识是 :未来 MLCP 和冷板将长期并存,而不是“二选一”。冷板厂凭借产能和成熟经验占据稳固地盘,盖板厂则在前沿技术上寻找突破,最终谁能胜出,关键看谁先把可靠性和良率跑通。

4. 三种技术路径(仍在测试验证阶段)

台积电式 :在芯片上用激光雕刻微通道,再以金属盖板形成流道,大流量带走热量。挑战在于水与金属接触后金属离子可能溶出,绝缘和密封难度高。业内普遍认为,当功耗突破 3000W 时几乎不得不用 。

英特尔式 :用铟片焊接金属盖板和芯片,凭借低熔点与柔性减轻应力,工艺相对成熟。

微喷射式 :不断向芯片表面喷射液体,利用蒸发来吸热。概念前卫,但目前仍处早期研究。

5. 技术难点

微通道的宽度只有零点零几毫米,加工精度要求极高;同时对洁净度的要求比现有液冷再高一档。业内提醒:哪怕一粒灰尘,都可能导致堵塞。

六、成本与商业化门槛

MLCP听上去很美,但真正能不能跑出来,还得过三道关:

第一关:成本门槛

有消息称,MLCP价格较现有冷板高约三到五倍(以后续订单为准)。这不是小差距,而是行业的分水岭。谁能把成本打下来,谁就能拿到订单;打不下来,就只能停在小规模试用。

第二关:制造门槛

微通道结构对加工精度和密封要求极高。只要有一点偏差,就可能堵塞或渗漏,直接报废。良率稳不下来,成本就会被进一步推高,这是产业能不能量产的关键。

第三关:市场门槛

MLCP主要针对的是超高功耗GPU。对大多数功耗在千瓦以下的产品,它并非必需品。这意味着它不会“一统江湖”,而是先在高端机型站稳,再看能不能向下渗透。

对投资者来说,这三道门槛才是真正的考题。技术先进只是起点,能不能把成本、制造和市场三关同时打通,才决定谁能真正吃下这块蛋糕。

七、应用与时间表

MLCP不会一夜之间铺满整个市场,它更像是一场“分批上场”的比赛。

第一步:先用在最极端的GPU上

据报道 ,英伟达下一代Rubin平台的功耗约2000–2300W ,尤其是双芯片版本,散热压力最大。产业链消息称 ,这类产品更可能率先采用 MLCP,以确保温度更可控。

第二步:单芯片可能暂时观望

相比之下,单芯片GPU的功耗虽然也高,但还没到“非MLCP不可”的程度。据业内口径 ,短期内,它们可能继续沿用传统冷板,成本更可控。

第三步:客户验证要时间

散热方案不像软件,跑几次基准测试 就完事。它要在真实机柜里进行长期运行的试用(客户验证) ,才能看出稳定性。据报道,MLCP仍需约3–4个季度的客户验证,之后才可能进入更大规模出货。

第四步:渗透节奏偏慢

即便验证通过,它也不会马上覆盖所有GPU和服务器。最可能的路径是:高端机型先用→大数据中心小批量部署→成本下降后逐步推广。

对投资者来说,时间表很清晰:

最快在2026年下半年 ,有望看到规模应用MLCP的GPU出货;

2027年以后 ,如果验证顺利、成本逐步下降,才可能看到更广泛的应用。(Rubin系列按官方口径预计在2026年末可用,具体采用以后续发布与客户落地为准。)

MLCP被多方视为趋势,但其商业化是‘马拉松’,不是‘百米冲刺’。

八、风险清单:投资者要防的三颗雷

再性感的技术,也有可能翻车。MLCP目前最大的风险,不在概念,而在落地:

1.可靠性未被验证

微通道要在真实机柜里跑上几个月甚至更久。腐蚀、渗漏、金属离子析出,这些问题都可能在长期运转中冒出来。短期实验没问题,不代表能扛住数据中心的长跑。

2.替代方案竞争

液冷不是只有MLCP一条路。改良冷板、双相冷却、浸没式、3D打印通道,全都还在跑道上。如果这些方案先把可靠性和成本跑通,MLCP的份额就可能被分流。

3.应用范围有限

MLCP针对的是2000W以上的极端GPU。普通服务器、边缘算力没必要用这么贵的方案。换句话说,它不会“一统江湖”,只能先在高端市场立足。

要记住 :

可靠性没跑通,大客户不会下单 ;

替代方案成熟,MLCP可能被边缘化 ;

市场范围有限,天花板比想象中更低 。

MLCP的故事能不能兑现,不取决于“酷不酷”,而取决于能不能稳、能不能跑得久。

九、冷兵器革命,时间来裁决

AI的竞争,走到今天,已经不仅是算法和芯片的比拼,而是能源与冷却的战争 。英伟达推动MLCP,不是为了炫技,而是被逼到门口:在2000W级GPU场景下,若无更高效冷却,持续稳定运行将面临更大挑战。

对产业链来说,MLCP是一道新的分水岭。它让散热件的价值量从“配角”变成了“核心环节”,也让冷板、盖板厂商有了翻身的筹码。但别忘了,这条路布满荆棘:制造良率、长期可靠性、成本控制、替代方案,每一个都是必答题。

对投资者来说,MLCP的意义并不在于“普及”,而在于它释放的信号:算力扩张的门槛再次被抬高,价值链正在重组 。谁能先把冷却性能与成本平衡跑通,谁就是下一轮大赛道的赢家。