关于大模型、AI和芯片等问题,微软CEO怎么看?

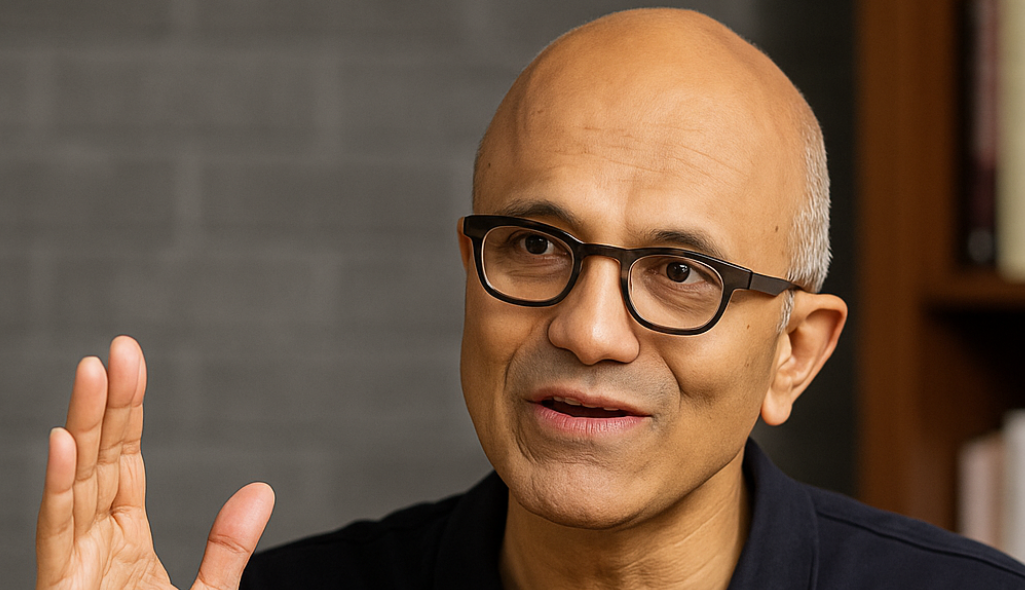

近期,微软CEO纳德拉做客知名科技博主Dwarkesh Patel的播客。他用一整期节目,把他对AI行业长期积累的理解压缩成一套清晰的方向坐标。

这不是一场普通的媒体访谈。没有营销式语言,也没有刻意装饰。更像是一位长期操盘大型技术体系的决策者,对现在和未来AI等行业的真实想法表达。他给出的信息并不激进,却足够穿透;不浮夸,却足够决定方向。

纳德拉谈到了Azure,AI的竞争结构,模型公司的脆弱性,平台的长期价值,Copilot,以及AGI。他提供的是一套整体结构,而不是一句口号。在一个充满高速叙事的行业里,这些观点非常值得关注。

Azure:它从来不是“租算力”,而是企业AI化的操作系统

外界常常将云业务视为“算力提供者”。但纳德拉谈Azure时,表示Azure/AI工作负载不仅需要AI加速器,还需要大量配套支持。事实上,我们的利润空间很大程度上就来源于这些配套服务,要将Azure打造成为长尾工作负载的终极平台,这才是超大规模云业务的本质。

“我们每 18 个月就在训练算力上为 OpenAI 模型扩大 10 倍。我们意识到,关键不只是继续扩大训练规模,还要在全球范围内实现「推理服务」的平衡。”纳德拉指出,“一旦我们意识到这一点,我们就调整了路径。现在我们重新加速开工,同时大量购买「托管容量」——不论是自建、租赁,还是通过 GPU-as-a-Service 的形式。我们要建设的,是能同时满足训练和推理需求的灵活算力。我们不想变成只为一家企业提供托管服务的「代建公司」。”

Azure的战略因此不再是“把GPU卖出去”,而是构建一个让所有客户能稳定、高效、可持续使用模型的全功能生态。

这也是为什么微软投入巨资强化AIStack、开发工具链、统一安全体系,并把这些结构沉淀到Azure中。这套结构化能力,不是随模型变化而波动的,而是越使用越深、越沉淀越牢。

“我不想被某一代硬件套牢。原来有GB200,如今 GB300 已经来了,再到下一代 VeraRubin、VeraRubinUltra,每一代数据中心在每机架功率、每行功率上都会完全不同,散热方式也会完全不同。

所以我不能盲目地建出几吉瓦、却只能适配一代硬件的设施。节奏、灵活性、地理分布、任务类型和客户多样性——这才是我们要追求的。”纳德拉总结道。

在讨论AGI时,纳德拉的表达极为冷静。他认为AI作为新的技术基础设施,将带来商业上的一系列变化,“其实商业模式的基本杠杆不会变:广告、交易、设备毛利、订阅和云消耗,这些仍是主轴。区别只是定价和层级。过去,你为一段使用量付费,AI订阅会延续这种逻辑。我们在所有这些模式上都有布局,这正是微软的优势。而且历史证明:低ARPU并不坏。当年我们从服务器迁移到云时,也担心利润会被吃掉,但云让市场大幅扩张。AI也会重演这个故事。以编码为例:我们用了十几年建立GitHub和VSCode,而一年内Copilot已经让整个类别爆发。这就是市场扩张的威力。”

Copilot:模型公司可能陷入“赢家诅咒”

很多人将Copilot看成一项单独功能,但纳德拉的理解远比这更深。

在谈Copilot时,他并没有描述某个炫技能力,而是强调它作为入口层的意义。它帮助用户跨应用完成任务,统一界面逻辑,减少复杂操作,并将模型能力自然嵌入到工作流中。

“在 GitHub Copilot 里,我最喜欢的设置是“Auto 模式”——它会自动选择最优模型去完成任务,甚至在多个模型之间切换。未来,模型可能成为可替换的商品,而真正的价值在于掌握‘数据 + 脚手架’的一方。尤其是随着开源模型的发展,任何人都能拿 checkpoint 加上自己的数据重新训练。所以模型公司可能面临“赢家的诅咒”:投入巨大创新成本,但成果很快被复制。拥有数据流动性(和上下文工程的人,反而可能主导价值。”

自研芯片和光器件:硬件进步才能带动算力提升

当下,随着各大AI巨头都开始下大力气投入到AI数据中心的热潮中时,芯片就成了大家的众矢之的。众所周知,当下无论是主打算力芯片的英伟达,还是存储芯片的三星海力士,以及代工的台积电。产能不足的问题,几乎笼罩全行业。

也正因为此,自研芯片就成了很多AI公司的选择。当被问及当下微软的自研芯片,为什么会落后于谷歌和亚马逊时,纳德拉表示,无论微软怎么投入芯片研发,当下也不可能绕开英伟达,“其实任何新加速器最大的竞争对手,其实是前一代的英伟达 GPU。即便是我们自家的芯片,比如 Maia 200,表现很好,但我们从 CPU 领域也学到了很多。当年我们先有 Intel,再引入 AMD,然后推出自研的 Cobalt。这就是我们如何在不同方案共存的情况下扩展规模。”纳德拉补充道,“即使是谷歌和亚马逊,他们也还在买英伟达的 GPU。这很合理,因为英伟达的产品通用、兼容所有模型、客户需求也大。我们会让自家的 MAI 模型与芯片研发形成闭环。”

而对于同属硬件的光器件领域,微软云与AI执行副总裁Scott Guthrie则从架构和性能上回答道,“我们力争每18-24个月将训练能力提升10倍。Fairwater2架构将使训练能力相比GPT-5提升整整10倍。” Guthrie补充道,“Fairwater4也将接入那个千万亿比特网络,实现超高速互联;AI广域网直通密尔沃基,那里正在建设多个Fairwater设施。从园区设计就能清晰看出其针对模型并行与数据并行的优化。”

除了Azure、API和硬件,纳德拉还提到了微软的人才观等议题,从总体上对AI和相关行业的发展做出了展望。可以看出,微软对未来AI的布局已经胸有成竹。他们正在构建一个从芯片、基础设施、大模型和应用的全方位 AI 生态。